Этика и прозрачность ИИ: право на объяснение

Современные ИИ-системы принимают все больше решений в критически важных сферах, включая медицину, финансы и правосудие. Эти решения часто оказываются непрозрачными, что вызывает необходимость в защите права человека на понимание того, как были сделаны выводы ИИ.

Право на объяснение — это концепция, утверждающая, что люди должны иметь доступ к пониманию того, как ИИ пришёл к своим выводам и решениям, особенно если эти решения влияют на их жизнь. Европейская директива GDPR, вступившая в силу в 2018 году, содержит положения, закрепляющие это право.

Проблема «черного ящика»

Алгоритмы глубокого обучения, лежащие в основе ИИ, сложны и трудны для понимания. В большинстве случаев даже разработчики не могут объяснить конкретный процесс, через который ИИ пришёл к своему решению.

Современные ИИ-системы, такие как IBM Watson, используются для диагностики и рекомендаций по лечению сложных заболеваний, включая онкологию.

Однако их решения иногда оказываются непрозрачными: пациенты и даже врачи могут не понимать, на каких данных и алгоритмах ИИ основывает свои выводы.

Например, в 2018 году IBM Watson предоставил несколько неверных рекомендаций по лечению рака из-за того, что его обучали на неактуальных и ограниченных данных.

Это подчеркивает необходимость в том, чтобы ИИ объяснял свои решения и обеспечивал доступ к источникам данных, чтобы повысить доверие и точность диагностики.

Алгоритмы, используемые для прогнозирования рецидивов у осужденных в США, также критикуются за непрозрачность. Система COMPAS, например, используется для определения уровня риска повторных преступлений.

Однако исследования показали, что алгоритм имеет предвзятость по расовому признаку, что ставит под вопрос объективность принимаемых решений и поднимает вопросы этики и прав человека на доступ к объяснению.

Почему это важно?

Без права на объяснение люди могут столкнуться с непредсказуемыми последствиями — отказом в кредите, отклонением медицинских рекомендаций или необоснованными обвинениями. Эти случаи поднимают вопросы о правах, справедливости и прозрачности.

ИИ-алгоритмы могут наследовать и усугублять социальные предвзятости, существующие в данных, на которых они обучены. Это особенно опасно в судебной системе и при найме на работу.

Законодательные меры для защиты права на объяснение

GDPR требует, чтобы граждане ЕС имели доступ к информации о принятии решений, основанных на ИИ. США также рассматривает подобные законодательные инициативы для повышения прозрачности.

Технологические подходы к прозрачности ИИ

Технологии, такие как интерпретируемые модели и визуализация данных, помогают разработчикам анализировать решения ИИ и повышать их понятность.

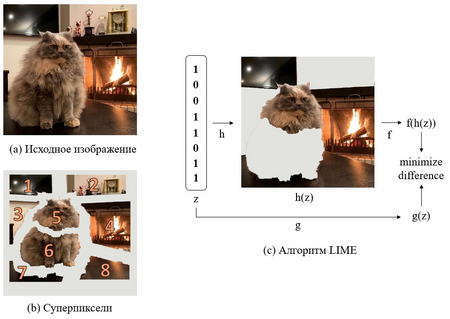

Алгоритмы, такие как LIME и SHAP, помогают понять, как ИИ принимает решения. Эти методы создают простые интерпретации сложных моделей, что повышает прозрачность.

LIME: Local Interpretable Model-agnostic Explanations

Основная работа, описывающая LIME, была представлена в 2016 году в документе под названием «Why Should I Trust You?»: Explaining the Predictions of Any Classifier»

LIME — это подход к интерпретации ответа модели на конкретном тестовом примере с помощью вычисления значений для некоторого конечного набора значений.

Психологические аспекты прозрачности

Когда решения ИИ понятны, пользователи меньше боятся последствий его применения, что снижает психологическое напряжение.

Для обеспечения доверия к ИИ важно развивать интерпретируемые и прозрачные системы, которые будут объяснимы и справедливы для всех.