Обучение нейросети для генерации серии иллюстраций

Введение

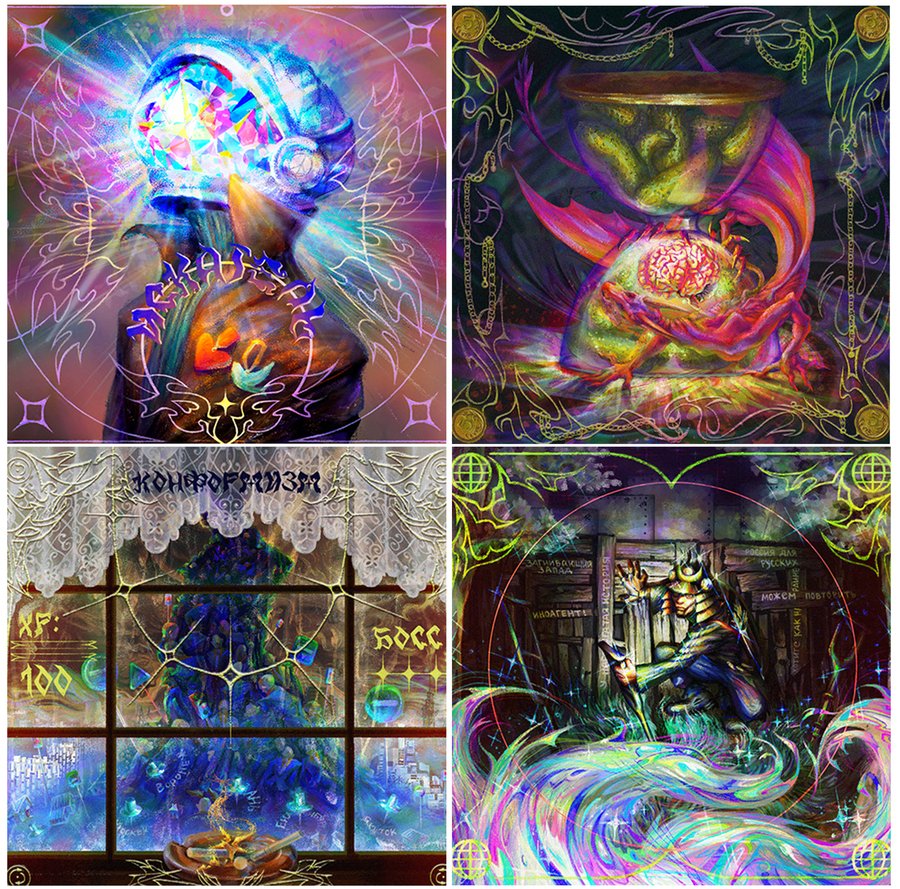

Используя код из курса по обучению нейросетей, я решила развить сюжеты нарисованных мною иллюстраций и проверить, на что способен дуэт DeepSeek + предобученная Diffusion Model. Мне интересно, насколько нейросеть может скопировать авторский стиль и какие параметры нужно учитывать при обучении.

пример использованного датасета

Обучение модели

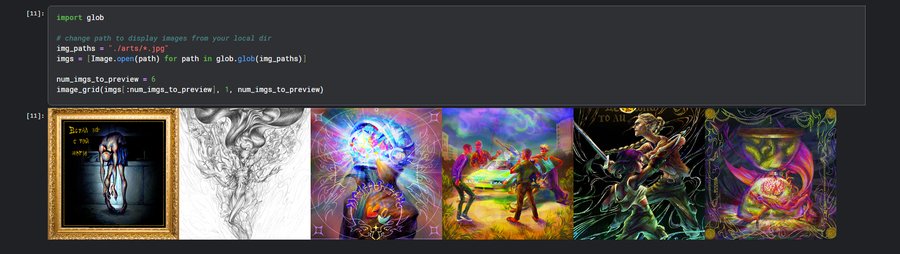

Шаг первый: загрузить все библиотеки (bitsandbytes, diffusers SDXL DreamBooth training script), и датасет в локальную директорию.

Шаг второй: с помощью модели BLIP определить объекты на каждом из изображений в датасете.

Третий шаг: создание токена в HuggingFace и обучение нейросети.

Параметры датасета и модели обучения

Применение генеративной модели

сгенерированные отдельно тестовые изображения

Для того чтобы начать работу мне нужны были промпты для генерации связанных между собой иллюстраций. Так выглядел промпт, поданный в работу DeepSeek без сгенерированных с помощью BLIP описаний изображений:

«Создай серию промптов для нейросети Stable Diffusion, чтобы создать серию иллюстраций. Я хочу чтобы иллюстрации отображали абстрактные понятия вроде „красоты“ или „доброты“, которые заложены в данном на вход нейросети датасете. Иллюстраций должно быть 10. »

Теперь нужно каждое сгенерировать последовательно 10 изображений и посмотреть, как в них отображается сюжет и авторский стиль.

Результирующая серия изображений

Пример промпта: «Chaos & Order, Photo collage in Veronika style, a fractured mirror reflecting both a storm and a calm sky, geometric shards blending into organic shapes, muted tones with bursts of red, abstract duality.»

Chaos & Order, Beauty

Kindness, Solitude

Hope, Serenity

Time, Courage

Love, Wonder

Итоги

Инструменты: 1. DeepSeek: генерация промптов для комиксов 2. Stable Diffusion: генерация изображений

В итоге, серия иллюстраций отражает авторский стиль лишь частично, хотя конечно видна схожесть в технике и композиции. Но для улучшения результата нужно дать на вход датасет с большим количеством картинок, отчетливее объединенных в одну стилистику.