Сны чернильного зверя | Обучение генеративной нейросети

Сны чернильного зверя — проект, посвящённый дообучению нейросети Stable Diffusion на работах художника Tyrus Wong для создания лиричной визуальной истории в его стилистике.

Концепция

Работы Tyrus Wong очаровывают своей поэтичной простотой, тонкой композицией и умением передавать глубину мира через едва намеченные формы и мягкий свет. Его вклад в визуальный стиль мультфильма Bambi стал знаковым примером того, как пейзаж может стать живым участником повествования — не фоном, а дыханием сцены.

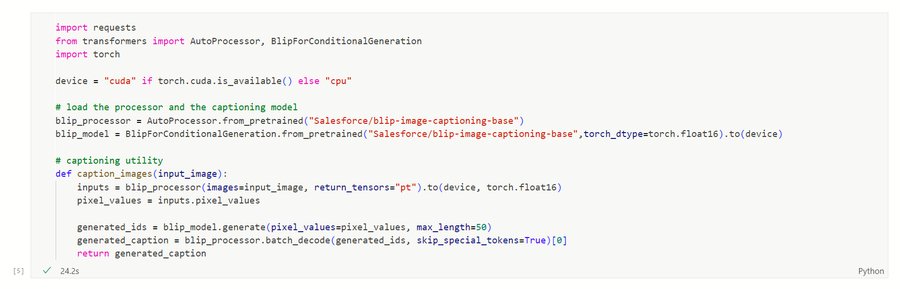

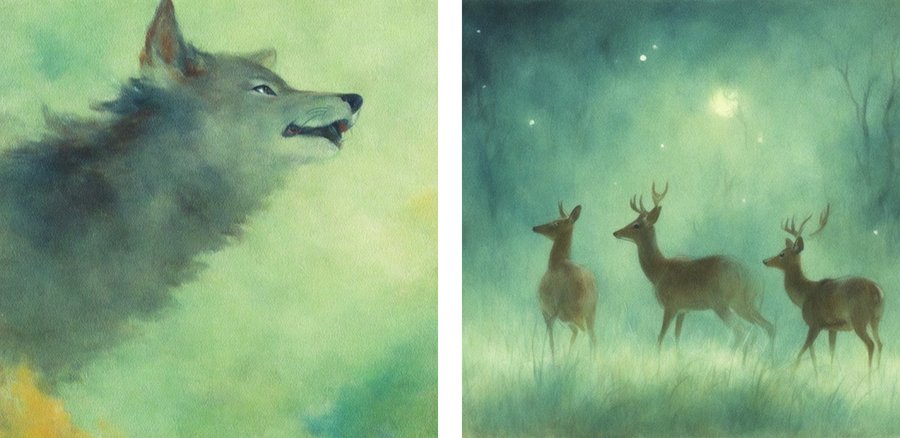

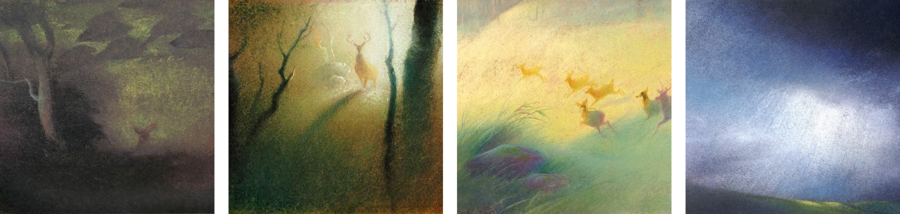

Работы Tyrus Wong

Вдохновившись этим подходом, я решила обучить генеративную нейросеть Stable Diffusion создавать изображения в стилистике Tyrus Wong и ему близких художников. Но в отличие от буквального воспроизведения его работ, я выстроила собственную концепцию — лирический визуальный рассказ от лица вымышленного персонажа, Чернильного Зверя.

Через генерацию изображений я хотела не просто воспроизвести эстетику Вонга, но и использовать её как язык — язык медленных образов, мистической природы и почти статичного времени. Проект строится на наблюдении за деталями и созерцании.

Работы Tyrus Wong

Цель проекта — передать дух работ Tyrus Wong, его мягкость, приглушённую палитру, размытые границы форм и ощущение сказочной ночи.

Итоговая серия изображений

Этот проект — визуальный дневник снов. Его герой — Чернильный Зверь, сущность, растворённая в тумане и ночи, наблюдающая за миром без слов. Он не путешественник и не герой — он свидетель.

Сны Зверя складываются в медленное, почти статичное движение через пейзажи: поле, реку, лес и рассвет у воды. Мгновение, застывшее между дыханием и светом.

Нейросеть, обученная на работах Tyrus Wong и близких по духу художников, смогла уловить особую эстетику — мягкость, дымчатость, поэзию образов. Результатом стала серия изображений, каждое из которых — часть одного сна, одного ощущения.

SD: a painting in TYRUS-WONG-ZVER style, vast nighttime field under a deep indigo sky, faint violet mist floating above the tall grass, stars softly glowing overhead

{ Звёздное поле }

Мир начинается в тишине. Перед нами — поле под тёмным небом, где трава колышется без ветра, а звёзды еле дышат сквозь фиолетовый туман.

SD: a painting in TYRUS-WONG-ZVER style, close-up of a single wolf paw print | a dark wolf-shaped shadow barely visible among mist and grass

Тень волка проходит меж травинок — не животное, но присутствие. След, оставленный в сырой земле, заполняется тьмой.

SD: a painting in TYRUS-WONG-ZVER style, night sky filled with scattered soft stars, some blurred, some sharp, subtle movement in cloud-like patterns

SD: a painting in TYRUS-WONG-ZVER style, close-up of dry wild grass bending slightly in a windless night, faint starlight casting silver edges on the stems, dark blurred background

SD: a painting in TYRUS-WONG-ZVER style, a lone deer standing still in a misty nighttime field, its antlers faintly catching starlight, body blurred into the fog

Где-то вдалеке — фигура оленя, растворяющаяся в дымке. Всё это написано мягкой кистью, в ночных серо-синих оттенках.

SD: a painting in TYRUS-WONG-ZVER style, close-up view of river surface at night, starlight scattered in soft white dots, ripples gently distorting reflections of tree silhouettes

{ Река, несущая свет }

Вода — как граница между снами. В ней отражаются не только деревья, но и птицы, что взлетают как чёрные сны.

SD: a painting in TYRUS-WONG-ZVER style, a mirror lake reflecting the night sky filled with endless cranes in flight, the fog

SD: a painting in TYRUS-WONG-ZVER style, wide slow river under the starry night, dark water with soft reflections of stars and trees, drifting mist above the surface, quiet mystical atmosphere

Сквозь прозрачную воду проглядывают камни, и каждый из них — как звезды, упавшие в реку. Всё замерло в беззвучной тишине.

SD: a painting in TYRUS-WONG-ZVER style, shallow river stones under crystal night water, the fog

SD: a painting in TYRUS-WONG-ZVER style, dense dark night forest at night with faint amber fireflies floating between trees, mist hanging near the ground

{ Лес света и теней }

Лес принимает Зверя как родного. Светлячки освещают путь, но не ведут.

SD: a painting in TYRUS-WONG-ZVER style, close-up of glowing fireflies in the dark forest, gentle yellow dots suspended in fog, surrounded by soft tree silhouettes | wolf walking slowly through

SD: a painting in TYRUS-WONG-ZVER style, small squirrel sitting quietly on a tree branch at night, faint firefly light reflecting in its eyes, fur slightly glowing with amber edges, forest deep behind

Сквозь кроны виднеется белка замершая на ветке. Здесь не нужно бежать — можно просто быть.

SD: a painting in TYRUS-WONG-ZVER style, close-up of tree bark with morning frost melting into thin line

Кора, листья, дыхание зверя — всё становится частью одной медленной симфонии.

SD: a painting in TYRUS-WONG-ZVER style, a coastal cliff overlooking a choppy sea, with mist at night, twilight sky with stars

{ Рассвет на берегу }

Он не просыпается — он просто исчезает.

SD: a painting in TYRUS-WONG-ZVER style, close-up of muddy pawprints on wet stones, disappearing into the mist

Следы на влажном камне бледнеют с каждой волной.

SD: a painting in TYRUS-WONG-ZVER style, howling black wolf stands on the cliff over the ocean sunrise, fog | lazy sunrise on the sea, the fog

Мир светлеет, но не становится ярким. Волк стоит на утёсе, смотрит в сторону ещё невидимого солнца.

SD: a painting in TYRUS-WONG-ZVER style, close-up view of a single droplet of water falling from the black ink wolf’s whisker into a still puddle | sleeping black wolf

Капля росы, дрожащая на листке, падает, а зверь лениво открывает сонные глаза. Это не финал — это тишина, завершающая круг.

Обучение генеративной модели

Для обучения использовалась модель Stable Diffusion XL, дообученная с помощью DreamBooth и LoRA. Основой стал датасет из 45 квадратных изображений в духе Tyrus Wong — преимущественно его собственные работы, а также несколько визуально и стилистически близких. Изображения были приведены к формату 1024×1024 и очищены от лишних элементов.

Фрагменты кода

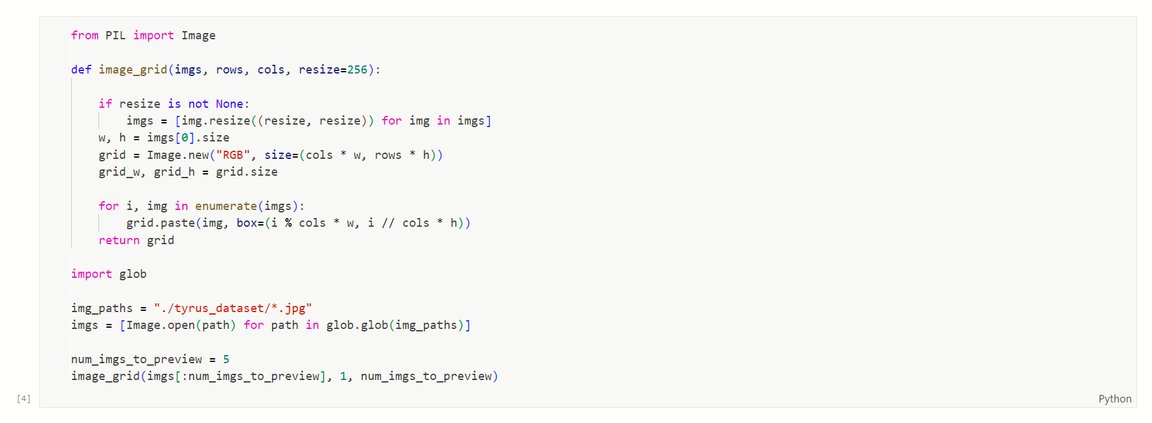

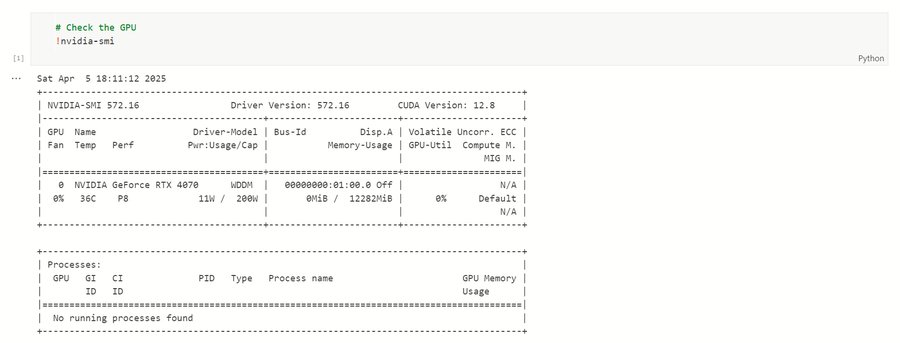

Первым этапом стала проверка доступности GPU и установка всех необходимых зависимостей в виртуальной среде через pip. Работа велась локально в VS Code на Windows, с использованием видеокарты RTX 4070.

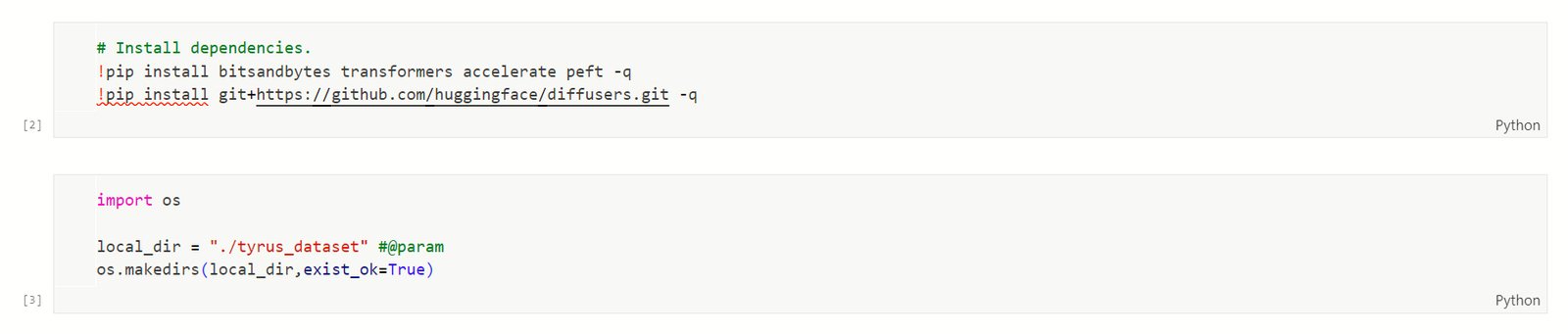

Была создана локальная директория для хранения датасета, подготовлены изображения и скрипты. Вместо загрузки на платформу Colab использовалась настройка окружения вручную — это позволило лучше контролировать процесс обучения и устранить ограничения по времени сессии.

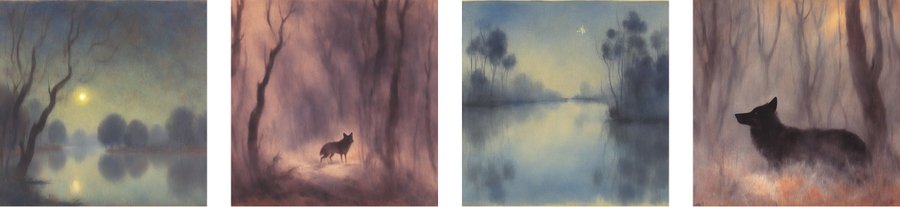

Фрагменты кода

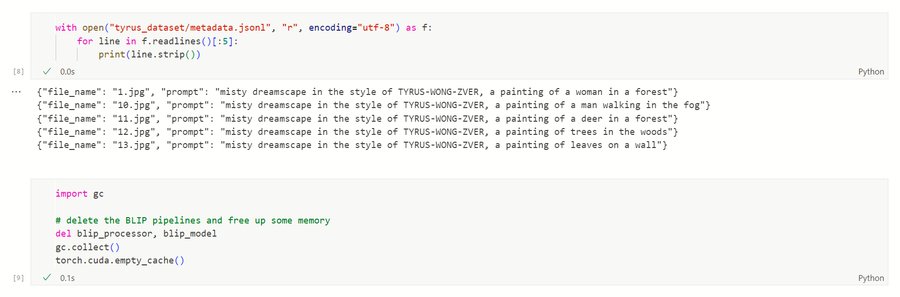

BLIP использовался для генерации автоматических описаний. К каждому изображению был добавлен префикс «a painting in TYRUS-WONG-ZVER style», отражающий заданное стилистическое направление.

Фрагменты кода

Обучение проходило локально на GPU, с настройкой ускорения через accelerate, использованием градиентного чекпоинтинга, 8-битного Adam и смешанной точности (fp16). Модель обучалась в течение 500 шагов.

Фрагменты кода

Проект реализован в одном Jupyter Notebook-файле, в котором последовательно выполнялись все этапы: подготовка датасета, генерация подписей с помощью BLIP, обучение модели Stable Diffusion XL с использованием LoRA и генерация финальной серии изображений. Файл загружен на Яндекс Диск.

Для тренировки использовался скрипт train_dreambooth_lora_sdxl.py из официального репозитория diffusers. После завершения модель была загружена на Hugging Face Hub и подключена для генерации серии изображений локально.

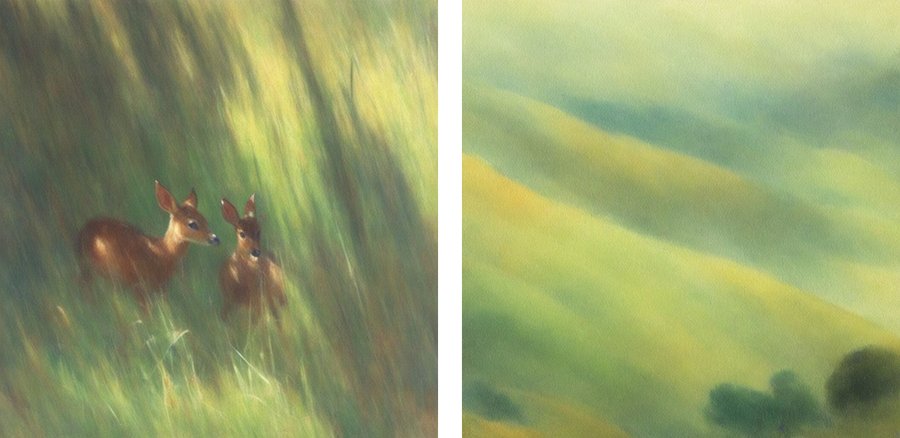

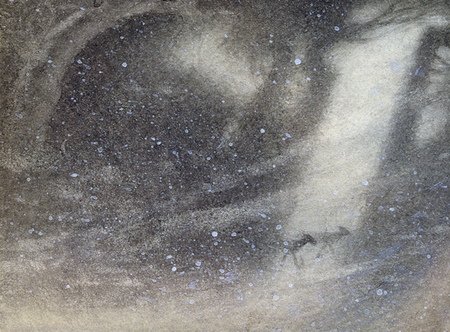

Примеры сгенерированных изображений

По результатам генерации наилучшие результаты показали пейзажи и фрагменты, содержащие один-два объекта. Нейросеть хорошо усвоила атмосферу — туман, тени, световые переливы, — хотя в ряде случаев сталкивалась с трудностями в деталях вроде количества ног животных или ближних планов.

Примеры сгенерированных изображений

Несмотря на это, итоговая серия получилась визуально цельной: кадры объединяет техника мягкого туше, спокойные темные палитры и характерное ощущение недосказанности — как будто каждый фрагмент действительно пришёл из сна.

Исходный код

Проект реализован в одном Jupyter Notebook-файле, в котором последовательно выполнялись все этапы: подготовка датасета, генерация подписей с помощью BLIP, обучение модели Stable Diffusion XL с использованием LoRA и генерация финальной серии изображений. Файл загружен на Яндекс Диск.

Применение генеративных нейросетей

Для обучения использовалась модель Stable Diffusion XL с LoRA. Промпты, структура проекта и уточнения по коду частично разрабатывались при помощи ChatGPT (GPT-4). Генерация и дообучение проведены с использованием библиотек Diffusers и платформы Hugging Face.